Intelligence artificielle : enfin l’enfance ?

- nb: vous pouvez écouter cette analyse sur le podcast I, Not Robot

L’intelligence artificielle a beau avoir discrètement franchi la cinquantaine, elle semble conserver les attraits du nouveau né. Un geste d’elle – on s’émerveille, on s’alarme. Portée haut par l’avant-garde de l’abstraction algorithmique et les machines les plus sophistiquées de l’industrie informatique, l’IA, fantasme enfin né à la réalité, attire tous les regards.

Elle fut, de la fin des années 1950 au tournant des années 2010, en gestation prolongée, à l’état d’ébauche compliquée dans les laboratoires de recherche en informatique, ou, taisant le nom qui allait faire sa gloire, exploitée discrètement comme outil d’aide à la décision, sous la dénomination de système expert. La voici devenue, en quelques années, technique généraliste en conquête accélérée de tous les secteurs d’activité. Et, où qu’elle se présente, elle fait la joie de ses futurs parents adoptifs, autant qu’elle angoisse celles et ceux qui vont devoir lui faire une place dans leur vie, sans nécessairement pouvoir peser sur son destin.

D’un côté, elle fait fondre les investisseurs, enchante les directeurs d’usine, ravit les ingénieurs. De l’autre, elle inquiète salariés et citoyens. Dans la sphère économique, l’intelligence artificielle promet de transformer bien des métiers. Dans la sphère sociale, elle pose de fort pressantes questions – allant de celle, centrée sur l’individu, des réactions à avoir face à la capacité des machines à identifier quiconque dans la rue à tout instant, à celle, touchant les grands équilibres sociaux, de la proportion d’emplois qu’elle pourrait faire disparaître.

Dans tous les cas, l’intérêt porté à l’IA, parfois excessif, n’est pas usurpé. Car à peine sortie de son berceau, elle surprend par ses capacités, authentiquement étonnantes. En médecine, elle a fait la preuve de son aptitude à détecter les indices de cancer, sur des radiographies, mieux que les meilleurs experts humains. Elle identifie, dans la voix des jeunes enfants, les signes caractéristiques de l’anxiété ou de la dépression, avec davantage d’acuité que les psychologues. Elle peut créer des tableaux à la manière du peintre dont on lui aura présenté des œuvres ; reconstituer un visage en trois dimensions à partir d’une seule photo. Sans compter son aptitude à attribuer une couleur émotionnelle à un discours, à traduire instantanément une langue dans une autre avec suffisamment de précision pour que deux interlocuteurs étrangers se comprennent. Ou encore son impressionnante capacité à battre les humains à des jeux toujours plus difficiles : échecs, go, shogi, jeux vidéos en ligne massivement multijoueurs (MMORPG)…

Les trois piliers de l’IA d’aujourd’hui

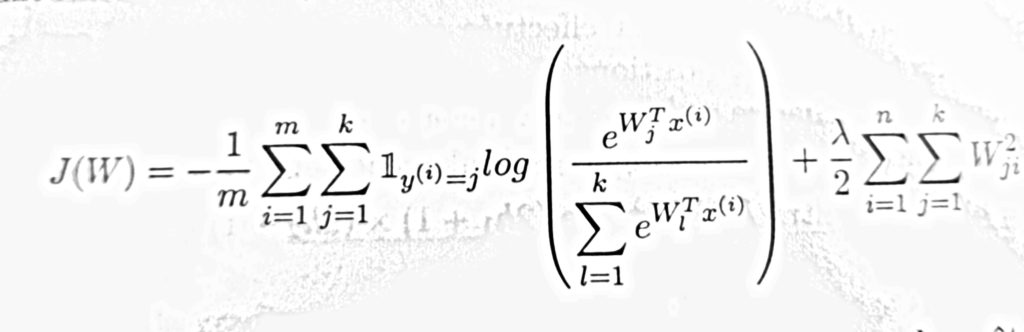

Derrière cette litanie d’exploits, trois conditions sont systématiquement réunies : une équipe scientifique ayant une compréhension très claire du problème à résoudre, des sources de données abondantes et pertinentes, et une sélection d’algorithmes bien choisis et bien articulés pour, à partir des données, apprendre à résoudre le problème posé. Dans la plupart des cas, les IA défrayant la chronique s’appuient sur des algorithmes dits d’ « apprentissage profond ». Ceux-ci fonctionnent tous, schématiquement, selon les mêmes principes. Une très grande quantité de données en entrée du système est traitée par des groupes de fonctions mathématiques reliées les unes avec les autres. Une fonction peut être assimilée à un « neurone », un groupe de fonctions à une couche de neurones. Le résultat du calcul effectué par les fonctions mathématiques, couche après couche, est comparé avec des valeurs cibles. Selon l’écart entre le résultat obtenu et ces valeurs cibles, les fonctions mathématiques sont modifiées automatiquement, jusqu’à ce que résultats et valeurs cibles atteignent une proximité jugée satisfaisante par les programmeurs. A ce stade, les couches de neurones ont « appris » à résoudre le problème posé. Face à de nouvelles données, inconnues mais concernant le même problème, elles sauront, immédiatement, trouver une solution.

Cette présentation est, bien sûr, très schématique. Mais elle donne une idée sans doute plus honnête de ce que fait une intelligence artificielle que la seule métaphore neurologique des « neurones artificiels », qui laisse un peu vite penser que l’IA s’apparente au cerveau humain. Car, en toute rigueur, le fonctionnement du cerveau est autrement plus complexe que celui des « réseaux de neurones » des IA les plus performantes. Surtout, l’apprentissage profond, en dépit de ses indéniables succès, reste incapable d’accomplir d’autres « tours » que ceux aujourd’hui tant applaudis.

Les IA émerveillent en effet par leur aptitude à traiter des problèmes qui, en réalité, sont peu ou prou toujours les mêmes : reconnaître des régularités connues dans des données inconnues (un visage donné parmi une collection de visages, par exemple), découvrir des motifs inconnus dans des données inconnues (classer automatiquement des visages selon des traits caractéristiques), prédire l’émergence d’un motif connu au sein de données inconnues (esquisser un visage à partir d’une partie des traits qui le constituent). L’IA « apprend », certes. Mais cet apprentissage est très limité. Et même les acteurs les plus en vue de ses développements s’en tiennent à des visées raisonnables. « A la fin, ce que l’on voudrait, ce sont des machines qui ont autant de bon sens qu’un chat de gouttière », rappelait en juin 2019 le Français Yann Lecun, directeur de la recherche en Intelligence Artificielle de Facebook, lauréat 2018 du prix Turing, invité à une soirée d’honneur au Consulat général de France à New York.

Une grande ambition : le chat de gouttière

Que faut-il à l’IA pour qu’un jour elle acquière autant de bon sens qu’un chat de gouttière ? Que lui faut-il, au-delà, pour réussir à se représenter le monde qui l’entoure, saisir et inventer des concepts nouveaux, appliquer ses connaissances à d’autres domaines que ceux dont elles sont issues… ?

Ces questions sont celles qui forgent la pointe des recherches contemporaines en IA. Et les chercheurs sont en train d’esquisser des réponses qui pourraient faire enfin sortir l’IA de son berceau. Leur conviction ? Celle que l’IA va devoir dépasser les dons innés que lui ont offert les algorithmes d’apprentissage profond, et trouver d’autres manières d’apprendre. Il lui faut désormais apprendre à apprendre. Comme un enfant s’engageant sur le long chemin de l’éducation, les progrès à venir de l’IA vont devoir s’appuyer sur un éventail d’outils pédagogiques bien plus étendu. Travaux théoriques, expérimentations et rapprochements disciplinaires portent la trace de cet acte suivant de l’IA. Ils pourraient aboutir à des IA équipés d’un « sens commun » rudimentaire, aptes à apprendre seules. Ce qui ramènerait les « prouesses » de l’IA actuelles au rang de sympathiques balbutiements… et ferait véritablement entrer les intelligences artificielles dans l’enfance, cette période d’intense développement de la puissance intellectuelle.

Parmi les chercheurs défrichant ces nouvelles pistes figure Josh Tanenbaum. Ce professeur au Département de Sciences cognitives et du cerveau au Massachusetts Institute of Technology a, en 2018, publié une synthèse, à la fois enthousiaste et pragmatique, expliquant pourquoi et comment l’IA devait prendre le chemin d’un progrès inspiré par la manière dont les humains apprennent pendant l’enfance. L’idée était dès alors non pas d’annoncer une révolution, mais de pointer les limites fondamentales des technologies d’apprentissage profond et d’envisager les moyens de leur faire franchir un nouveau cap conceptuel. Ce que pointe d’emblée Josh Tanenbaum, c’est la très faible efficacité de l’apprentissage des réseaux de neurones profonds face à celle des humains, lorsqu’ils sont confrontés à la même tâche. Le chercheur et son équipe s’appuient, notamment, sur la façon dont une IA parmi les meilleures du moment apprend à jouer à des jeux vidéos des années 1980.

236 heures pour gagner à un jeu d’arcade

En 2015, le système « DQN » , conçu par des chercheurs employés par Google, associant un réseau de neurones profond à des algorithmes d’apprentissage par renforcement, a appris à jouer à 49 jeux d’arcade issus du catalogue d’Atari. « DQN », ont montré ses concepteurs, a réussi à faire mieux qu’un joueur humain expérimenté pour 20 de ces jeux, aussi bien pour 9 d’entre eux, et a concédé la défaite pour les 20 autres. L’équipe de Josh Tanenbaum s’est en particulier intéressée à la manière dont « DQN » avait appris à jouer à « Frostbite ». Le joueur de Frostbite doit construire un igloo. Il saute d’iceberg en iceberg, récolte des blocs de glace et évite les obstacles (ours, oiseaux…). Autant dire que ce n’est pas un jeu difficile. Un adulte s’y essayant parvient à réaliser un score honorable en un temps relativement court (quelques heures au plus). Et si le même adulte observe un joueur aguerri, il lui faut encore moins de temps. L’IA développée par les chercheurs de Google a, elle, besoin de 236 heures pour atteindre un taux de réussite de 49 % – sachant qu’en manipulant de manière totalement aléatoire les contrôles du jeu, ce taux atteint 1,5 %. Au bout de deux heures d’apprentissage, le score de la machine ne dépasse pas 3,5 %, et atteint tout juste 19 % après 116 heures. En clair : « DQN » devient peut être un très bon joueur de « Frostbite », mais au prix d’un apprentissage extrêmement laborieux. Ce qui rend les joueurs humains si rapidement habiles à construire un igloo de pixels en sautant, sur l’écran, d’un iceberg à un autre ? « Les apprenants humains, contrairement au DQN et à tant d’autres systèmes d’IA apprenantes, approchent les nouveaux problèmes armés d’une expérience préalable très large, répond Josh Tanenbaum. Un humain rencontre ici un problème qui n’est jamais qu’un problème parmi une chaîne formée des années durant, et ces problèmes rencontrés au préalable partagent bien souvent des éléments de structure ».

Autrement dit: quand il fait une expérience aussi artificielle que celle consistant à découvrir ce qui fait gagner à un jeu d’arcade, tout humain, aussi rétif aux écrans soit-il, peut s’appuyer sur tout ce que la vie a pu lui apprendre. Comme savoir, et cela dès les premiers mois de vie, qu’il y a souvent intérêt à être attentif aux éléments qui se déplacent dans le décor – que ce soit dans une rue animée ou sur l’écran d’un jeu d’arcade. L’IA, elle, au moins dans ses premiers pas d’exploration, n’a aucune raison de s’intéresser à un pixel plutôt qu’un autre. « Si nous voulons concevoir des machines qui apprennent et pensent comme des humains, alors nos machines doivent se confronter aux tâches à la manière des humains, poursuit naturellement le chercheur du MIT. Les gens ne partent jamais de rien, et c’est le secret de leur réussite. Le défi devient : comment arriver à disposer très vite de connaissances a priori pour apprendre à résoudre très vite de nouveaux problèmes ? »

Et quel défi ! Rien moins que réussir à « équiper » les IA de programmes qui, à l’instar du cerveau d’un très jeune enfant, sera capable d’extraire très vite, et avec une fantastique efficacité, des informations utiles à partir de son environnement. Est-il envisageable de faire se développer une IA comme se développe l’esprit d’un enfant ? Ou à défaut, au moins, d’en faire un honorable chat de gouttière ? Rien n’est acquis. Mais la voie est ouverte, y compris par celles et ceux qui travaillent au plus près des applications industrielles de l’IA. Ainsi certains chercheurs travaillant dans les unités de recherche et développement d’Uber (Uber AI Labs), en marge de leurs travaux centrés sur les logiciels de conduite autonome, contribuent à préparer la génération suivante d’IA, en expérimentant de nouveaux algorithmes dotés de plasticité. Soit des algorithmes dotés de la capacité, après un apprentissage, de reconfigurer partiellement leurs connexions entre « neurones »1 – pour accomplir une tâche légèrement différente, par exemple. « Je travaille sur le développement de réseaux de neurones qui demeurent capable d’apprendre après leur apprentissage initial. L’idée est de former des réseaux de neurones qui, une fois « lâchés » dans leur environnement, sans guidage, restent capables de modifier leur comportement. Cette plasticité les aide à apprendre de manière plus efficace », explique Thomas Miconi, ingénieur de recherche chez Uber.

Le levier de la plasticité, pour aider les machines à « assouplir » leurs capacités d’apprentissage, est fortement inspiré des processus de maturation observée, dans l’enfance, au cœur du cerveau humain. A sa naissance, un nouveau-né dispose, déjà, d’environ 100 milliards de neurones. Seule la moitié de ces neurones sont alors connectés entre eux. Mais minute après minute, environ 2 millions de connexions vont se mettre en place, sous l’influence de facteurs génétiques et des interactions avec l’environnement. Doter une machine ne serait-ce que d’une fraction modeste de cette formidable plasticité, dans la durée – et pas seulement à l’occasion d’un apprentissage initiale effectué dans un but précis – c’est lui donner des chances de pouvoir adapter son comportement à un environnement complexe et changeant.

Reste que, chez les humains, cette plasticité n’est pas absolue : le cerveau de sapiens évolue intensément dans les premiers mois de vie, puis continue à se transformer, jusqu’à la mort. Mais il hérite, aussi, de contraintes imposées par l’évolution, qui inscrivent dans les grands schémas de connexion et de fonctionnement biochimique de ses neurones des dynamiques de réponse organisant, d’emblée, la manière dont un humain appréhende le monde.

La plasticité n’efface pas l’inné, et les êtres humains, avant même de faire l’expérience du monde, partent avec quelques millions d’années d’évolution d’avance sur les machines. Or figure dans cet héritage naturel ce que les spécialistes du développement cérébral assimilent aujourd’hui à de véritables théories. Ce qui fait dire à Stanislas Dehaene, titulaire de la chaire de Psychologie cognitive expérimentale au Collège de France, que « […] pour parvenir à une véritable IAG [Intelligence Artificielle Générale, ndr], c’est probablement le principe même de nos architectures informatiques qu’il faut revoir, parce que le cerveau humain à la différence des autres espèces animales, semble posséder des algorithmes très spéciaux pour formuler des théories du monde extérieur. Il parvient à explorer systématiquement toutes les combinaisons de toutes les règles possibles, à l’aide d’une sorte de langage de la pensée en s’appuyant sur la théorie des probabilités. […] Seule la manipulation des probabilités, c’est à dire des incertitudes sur ce qu’on a appris, permet de tirer le maximum de chaque information. C’est la théorie du cerveau statisticien »2.

Cette théorie est bien connue des chercheurs en intelligence artificielle. Sans surprise, elle fait partie de l’éventail des voies à poursuivre établi par Josh Tanenbaum. « A l’âge de deux ans, probablement avant, les enfants s’attendent à ce que les objets inanimés respectent des principes de persistance, de cohésion, de continuité et de solidité. Les représentations cognitives sous-jacentes peuvent être comprises comme des théories intuitives, avec une structure causale ressemblant à celle des théories scientifiques, retient-il pour sa part3. La proposition de l’enfant scientifique voit même un aspect scientifique dans le processus d’apprentissage lui-même, des expériences récentes montrant que les enfants cherchent à obtenir de nouvelles données pour distinguer des hypothèses, isoler des variables, tester des relations de causalité… ».

Faire émerger les théories scientifiques

Parmi ces expériences, citons celles du Laboratoire de sciences cognitives et psycholinguistique de l’ENS, à Paris, qui montrent qu’avant deux ans les enfants sont, déjà, sensibles à la syntaxe : ils jugent anormales des phrases où verbes et noms sont placés de manière erronée. Citons encore, à Paris toujours, celles menées par le laboratoire de Psychologie de la perception, de l’université Paris-Descartes, qui attestent que des nouveau-nés âgés d’une trentaine d’heures seulement possèdent une représentation abstraite du nombre1.

Peut-on imaginer écrire le code informatique qui offrirait aux IA des aptitudes aussi essentielles, avant même de les exposer aux immenses réservoirs de données qui constituent aujourd’hui leur seul bagage ? « Il n’y a pas d’accord sur la nature computationnelle [des principes et concepts innés chez les enfants], reconnaît Josh Tannebaum. Ont été évoqués des arbres de décisions, des listes de règles… et une approche prometteuse, récente, voit la physique intuitive fonctionner comme les logiciels de simulation de réalité physique qui sert de base aux films d’animation et aux jeux vidéo. Selon cette hypothèse, les gens reconstruisent les scènes perçues en utilisant une représentation interne des objets et de leurs propriétés physiques (masse, friction, élasticité…) et des forces s’y appliquant (gravité, friction, collision…) ».

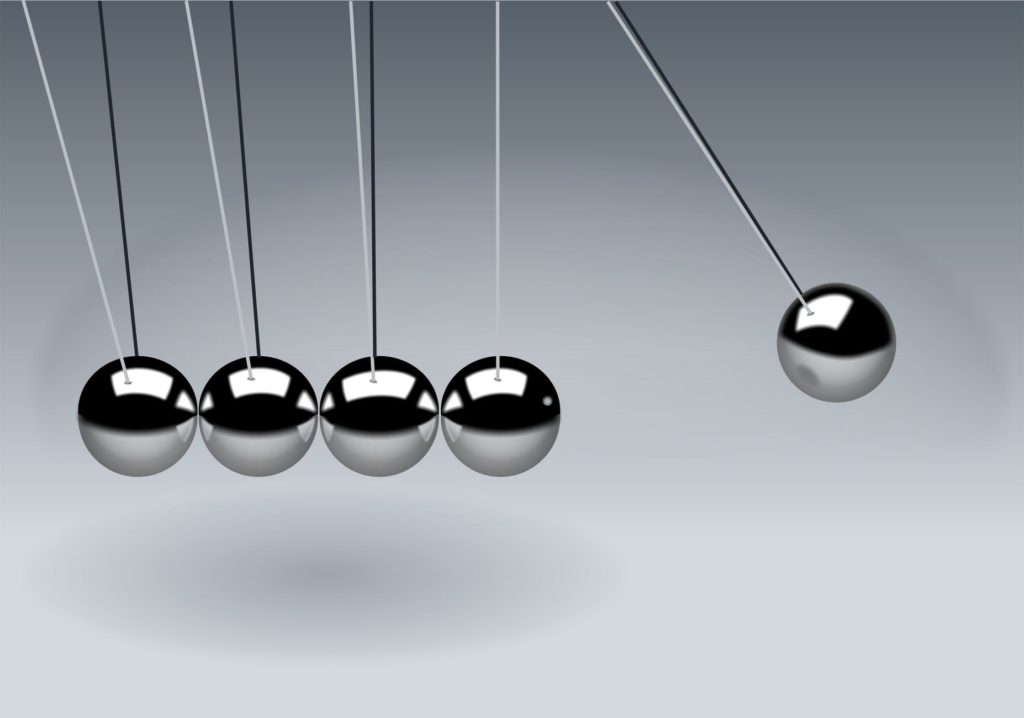

Ces pistes commencent, modestement, à porter leurs fruits. Dès 2016, des chercheurs de Facebook AI Research2 sont parvenus à entraîner un réseau de neurones artificiels dit « convolutionnel » à prédire la stabilité d’une tour (virtuelle) constituée de quelques cubes, à partir de scènes simulées, montrant des tours tantôt stables, tantôt instables. Ce réseau a « inventé » ses propres lois de mécanique newtonienne et réussi, ensuite, aussi bien que les humains, à prédire ce qu’il adviendrait de vraies tours faites de vraies cubes… au prix d’un apprentissage initial de plus de 100 000 scènes.

Plus récemment, une équipe de neuroscientifiques allemands a découvert, dans les couches profondes d’un réseau de neurones profond développé pour classer des images de formes différentes (carrés triangles, cercles) sans critère préétabli, qu’émergeait spontanément le « sens du nombre » : le réseau classait les milliers d’images qui lui étaient soumises en fonction de leur quantité pour chaque forme présentée.

Ce dernier résultat est encourageant, car il signe la possibilité de cultiver la construction d’abstractions au sein-même des technologies d’apprentissage existantes. Certes, cette découverte ne dit rien de la manière dont devraient être conçus les algorithmes d’apprentissage pour, précisément, faire émerger concepts et capacité d’abstraction. Mais, sur ce plan, un outil très récemment développé par les équipes de la société Deepmind, à qui l’on doit AlphaGo (première IA ayant battu des maîtres du go), pourrait être d’un secours précieux. Appelé Psych Lab, il consiste en un environnement virtuel, reproduisant un poste d’expérience de psychologie cognitive.

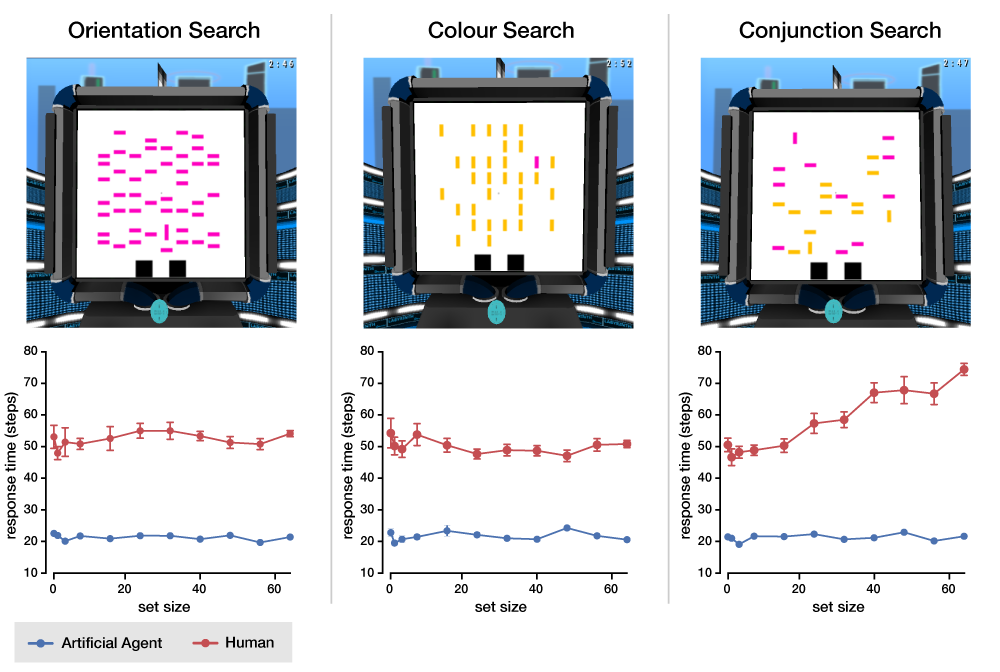

Les psychologues, pour percer les mystères du fonctionnement de l’esprit humain, ont conçu des expériences très simples, dès les années 1950, qu’ils font passer à des volontaires. Le plus souvent, elles consistent à faire s’asseoir les volontaires devant un écran relié à un ordinateur et à un clavier, et à appliquer des consignes simples. Fixer une croix apparaissant un instant sur l’écran, puis être attentif à des formes ou des couleurs qui y apparaîtront, quelques minutes durant, par exemple. La consigne peut alors être d’appuyer sur un bouton si une forme inédite apparaît, ou d’appuyer sur le même bouton quand un certain nombre de formes identiques sont apparues… Les psychologues ont imaginé des dizaines d’expérience de ce type, et les ont standardisées. Ils mesurent les temps de réaction, les taux d’échec ou de réussite… et comparent les résultats d’individus d’âges ou de conditions de santé différentes. Ils en tirent des hypothèses sur la manière dont l’esprit humain dirige son attention, compte, se souvient, perçoit des différences, etc.

Les IA passent chez le psy

L’idée des chercheurs de Deepmind est, sur le principe, très simple : faire passer ces tests bien connus à des IA, en les « branchant » devant un écran virtuel, pour leur faire passer virtuellement les mêmes tests que ceux proposés aux sujets humains, et dont les résultats sont parfaitement connus. Le projet Psych Lab, initié en 2108, n’en est qu’au stade exploratoire. Mais ses concepteurs, soumettant à des tests psychométriques de vision une IA appelée « UNREAL », ont d’ores et déjà établi des différences notables entre la façon dont « voit » cette IA et les caractéristiques humaines de la vision. Un premier pas pour comprendre et influencer la manière dont les machines s’approprient le monde.

Pour faire grandir les IA et étendre leur champ de compréhension, et comme en complément à cette approche de laboratoire, à l’environnement virtuel parfaitement maîtrisé, la robotique développementale avance elle aussi ses pions. Là où les experts des IA travaillent sur la montée en puissance des capacités innées des machines, les roboticiens veulent, eux, nourrir la richesse de leurs interactions réelles avec le monde. Ils misent sur « l’apprentissage développemental » pour accélérer l’acquisition de connaissances par les machines, et rendre leur comportement plus pertinent, grâce à l’instanciation physique des IA sous la forme de robots évoluant dans le monde réel, en interaction avec les humains. « En mettant l’accent sur l’interaction avec le monde physique, l’idée est d’exploiter une forme d’apprentissage plus efficace et rapide, plutôt que d’apprendre sur la base de milliers ou millions d’exemples, en photos ou vidéos. Cela peut aussi faciliter la transposabilité des tâches accomplies par les machines : pour un bras robot, la manipulation d’un verre doit être très vite équivalente à la manipulation d’une tasse », explique Amélie Cordier, directrice scientifique d’Hoomanoo, entreprise développant des robots sociaux.

La belle affaire, que de savoir se saisir d’une tasse quand on sait se saisir d’un verre ? Pour un adulte, assurément. Mais observez un enfant entre 1 an et 2 ans s’essayer à ce petit exploit domestique. Et songez à ce que pourrait accomplir une machine aussi douée qu’un enfant de trois ans. L’IA entre dans l’enfance. Il sera bientôt temps de décider de quelle éducation nous voulons lui donner.

Références

- J. Tanenbaum et al., Building Machines That Learn and Think Like People, AAMAS ’18 Proceedings of the 17th International Conference on Autonomous Agents and MultiAgent Systems , 2018

- T. Miconi et al., Differentiable plasticity: training plastic neural networks with backpropagation, Proceedings of the35thInternational Conference on Machine Learning, Stockholm, 2018

- Stanislas Dehaene, « Apprendre ! Les talents du cerveau, le défi des machines », Odile Jacob, 2018

- A. Lerer et al., Learning physical intuition of block towers by example, arxiv.org, 2016